Empörung auf KnopfdruckWie KI-Inhalte Teil einer altbekannten Dramaturgie werden

Der Wahlkampf um die Bundestagswahl im Winter 2025 ist von Neuerungen geprägt – beispielsweise vom Bündnis Sahra Wagenknecht, das erstmals auf Bundesebene antritt.[1] Es ist aber auch der erste Bundestagswahlkampf, in dem Inhalte im großen Stil und von Aktivist:innen wie auch politischen Laien mit Künstlicher Intelligenz (KI) generiert werden können. Von Accounts der Alternative für Deutschland (AfD) wurde beispielsweise ein Video verbreitet, in dem die ehemalige Bundeskanzlerin Angela Merkel unvorteilhaft verändert wurde;[2] auch die AfD-Kanzlerkandidatin Alice Weidel wurde Opfer einer KI-Retusche. Als sie ein Magazin dazu aufforderte, ein von ihr mittels KI generiertes Bild zu löschen, kam das Medium dieser Bitte nach – nur um kurz darauf ein ebenfalls KI-generiertes Bild von Weidel im weißen Gewand mit AfD-Logo und mit Heiligenschein zu veröffentlichen.[3] Die Nutzung von KI, um Bilder von Personen zu generieren, greift tief in deren Persönlichkeitsrechte ein – etwa in das Recht am eigenen Bild. Die kleinen Veränderungen, die etwa Merkel unvorteilhafter aussehen lassen, oder die überspitzte Darstellung von Weidel als Heilige illustrieren die Ambiguität und das manipulative Potenzial des generierten Materials.

Zwar ist KI-Nutzung im Wahlkampf bislang noch ein Nebenschauplatz. Ihre Massenverbreitung hat jedoch in den vergangenen Jahren, besonders jedoch mit der Veröffentlichung von ChatGPT im November 2022,[4] große Aufmerksamkeit auf sich gezogen: Insbesondere Rechenmodelle, die Texte, Bilder, Videos und Musik ausgeben können – sogenannte generative Künstliche Intelligenz –, haben eine Welle der Begeisterung, der Medienaufmerksamkeit und von Investitionen in den KI-Sektor nach sich gezogen.[5]

Doch auch die Kritiken und Sorgen, die mit der Massennutzung einhergehen, sind vielfältig und schwerwiegend. Sie reichen von der Kritik des exorbitanten Wasserverbrauchs der benötigten Rechensysteme[6] über die Verletzungen von Urheberrechten durch die Einspeisung als Trainingsdaten (beispielsweise wenn urheberrechtlich geschützte Texte oder Bilder ohne Wissen oder Zustimmung der Verfasser:innen genutzt werden, um eine KI zu trainieren),[7] die Fehlerhaftigkeit von Sprachmodellen[8] bis zur massenhaften Produktion von Desinformation durch KI.[9]

Dieser Beitrag widmet sich der Nutzung von KI-Inhalten durch rechte Gruppierungen; insbesondere untersucht er ihre Strategie, durch KI-Inhalte Medienaufmerksamkeit zu generieren. Der Beitrag geht hierfür zunächst auf die grundlegenden Möglichkeiten ein, die KI (nicht nur) radikalen Gruppen bietet. Anschließend widmet er sich dem Stil, der mit KI-Inhalten assoziiert wird, und gibt einen Überblick über verschiedene Beispiele, in denen KI bereits für politische Zwecke genutzt wurde. Hierbei wird ein besonderes Augenmerk auf die Kommunikationsweise rechter Gruppierungen gelegt und beleuchtet, wie diese – nicht erst seit der Massenverfügbarkeit von KI – mediale Reaktionen hervorrufen können.

Unbegrenzte Möglichkeiten?

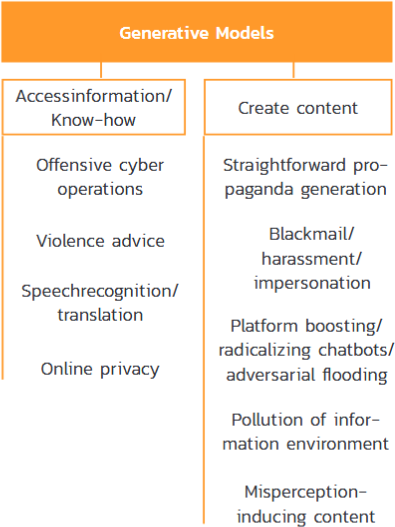

Künstliche Intelligenz kann als Werkzeug von jeder und jedem genutzt werden. Dies schließt auch radikale oder terroristische Gruppen ein.[10] Die Möglichkeiten, KI zur Zufügung von Schaden zu nutzen, sind vielfältig. Die Politikwissenschaftler Stephen Baele und Brace Lewys haben ausgearbeitet, wie KI von diesen Gruppen genutzt werden kann. Im Hinblick auf generative KI (andere KIs werden beispielsweise auf die Mustererkennung in der Medizin spezialisiert, etwa um Unregelmäßigkeiten in Röntgenaufnahmen zu erkennen) unterscheiden sie zwischen der Bereitstellung von Informationen und der Erstellung von Inhalten.[11]

So können Sprachmodelle beispielsweise Anleitungen zum Bombenbau oder Vorbereitungsschritte für Anschläge ausgeben. Zwar haben die Unternehmen, die generative KIs bereitstellen, Sicherheitsmaßnahmen gegen solche Anfragen eingearbeitet; Nutzer:innen können diese jedoch aushebeln.[12]

Neben der Bereitstellung von Wissen zählt auch die Generierung von Text-, Bild- und Videomaterial zu den Funktionen von KI. Dabei kann es sich um fotorealistische Bilder handeln, die entweder zu Erpressungszwecken genutzt werden können oder um sich als andere Person auszugeben. Weiterhin können Falschinformationen und Propagandamaterial erstellt werden. Baele und Lewys warnen daher davor, dass beispielsweise Social-Media-Seiten mit diesem KI-Material überflutet werden können. Plattformen, die zum US-amerikanischen Internetkonzern Meta gehören, wie Facebook und Instagram, planen zudem ihrerseits die Veröffentlichung von vollständig KI-generierten Profilen.[13] Dies erschwert die Unterscheidung zwischen realen Personen und Fake-Accounts sowie die zweifelsfreie Unterscheidung von gesicherten Informationen und Unwahrheiten.

Oft sind KI-generierte Bilder schnell als solche zu erkennen: Verschwommene Hintergründe, kräftige Farben und perfekte Formen, aber auch grobe Ungenauigkeiten und Eigentümlichkeiten charakterisieren den typischen KI-Stil.

In einem – für diesen Artikel mit DALL·E erstellten – Bild (siehe Abbildung 2) finden sich zahlreiche KI-Eigenheiten und Kuriositäten. So ist beispielsweise die Menschenmenge nicht dem Sprecher zugewandt, sondern dem Reichstagsgebäude. Auf einigen Flaggen, die in unterschiedliche Richtungen wehen, sind undefinierbare Kreissymbole zu sehen, die Protestschilder haben keinen lesbaren Text. Dennoch: Das Bild transportiert eine Proteststimmung.

Trotz dieser Fehlerhaftigkeit von KI-Material werden KI-Bilder in politischen Kampagnen und zur Illustration politischer Inhalte verwendet. Der Journalist Felix Huesmann hat eine dieser Kampagnen dokumentiert: In einem Facebook-Beitrag ist ein junger Mann namens Tobias Mayer aus der kleinen Gemeinde Bad Boll abgebildet. Das Bild ziert die klare Botschaft »Gesicht zeigen!«. Im Hintergrund ist unscharf eine Landschaft mit zwei Windrädern zu erkennen. »Ich bin AfD-Mitglied geworden, weil die Verspargelung der Landschaft überhandnimmt«, wird er zitiert. Gemeint ist, dass es zu viele Windräder gebe, die dem Zitat zufolge aussehen wie Spargelstangen. Die Botschaft fügt sich in die von der AfD vertretenen Positionen ein, denn für die Abschaffung aller Windräder hat zuletzt auch Alice Weidel im Januar 2025 im Zuge des Bundestagswahlkampfs plädiert.[14] Das Problem mit dem Bild: Der Mann existiert nicht, das Bild ist KI-generiert. Die Personen der Kampagne wurden teils für echte Personen gehalten.[15] Ein weiteres Beispiel unterstreicht die Emotionalisierung von Debatten, die durch KI-Material verstärkt werden kann. In einem Report des Centres for European Policy Network wird ein Screenshot eines X-Posts gezeigt. Ein AfD-Bundestagsabgeordneter hat ein KI-Bild geteilt, auf dem ein blondes Mädchen gequält den Betrachter:innen entgegensieht. Auf dem Bild steht »Chemnitz 13. März 2023 Afghane attackiert Mädchen mit Reizgas«, klein in der Ecke steht »Symbolbild | Midjourney«[16]. Die Bilder müssen nicht echt sein, um zu wirken.

Die Journalistin Friederike Haupt beschreibt in der FAZ, was die Nutzung von KI für die Politiker der AfD, die sich zur Nutzung von KI geäußert haben, interessant macht. Sie stellen vor allem heraus, wie unkompliziert und kostengünstig die Nutzung ist. Auch würde durch die neue Technik ein Zugang zu neuen, originellen Motiven anstelle der gewohnten Symbolbilder aus Bilddatenbanken eröffnet.[17]

Hohn und Humor in KI-Material

Neben Texten und Bildern können auch Lieder und Videos mittels einer KI erstellt werden. In einer Landschaft der (sozialen) Medien, in der audiovisuelle Inhalte zunehmend bevorzugt abgerufen werden,[18] nehmen diese Kunstprodukte einen zentralen Stellenwert ein.[19] Besondere mediale Aufmerksamkeit erlangte beispielsweise im Vorfeld der Wahlen in Brandenburg, Sachsen und Thüringen im Herbst 2024 ein umgedichteter Song mit KI-generiertem Video. In dem von der Jugendorganisation der AfD, der Jungen Alternative (JA), veröffentlichten Video wird eine imaginäre »Abschiebe-Fluglinie«[20] gezeigt. Der Songtext fantasiert über die Abschiebung aller Migrant:innen aus Deutschland. Schließlich stellte der ehemalige Grünen-Politiker Volker Beck deswegen Strafanzeige wegen Volksverhetzung.[21] Der Report der BAG »Gegen Hass im Netz« beschreibt die Wirkung des Videos: Obwohl es rasch von YouTube entfernt wurde, verbreitete es sich viral und

»avancierte in AfD-Kreisen sogar zum Theme-Song des Brandenburger Wahlabends. Über solche Provokationen sammeln sich im Umfeld der AfD immer mehr Accounts, die mit KI-generierten Bildern auf politische Entwicklungen reagieren. Dabei werden etwa konkrete Gruppen wie migrantisch gelesene Menschen negativ oder deutsche Politiker*innen als manipulativ dargestellt.«[22]

Obwohl die KI-generierten Personen in dem Video aufgrund ihrer unnatürlichen Verrenkungen albern wirken, sind es die hier transportierten politischen Inhalte mitnichten. Die Verbindung aus lächerlich aussehenden Verrenkungen und der Melodie eines Party-Songs mit radikalen Inhalten wirkt geradezu höhnisch.

Die dargestellte Lächerlichkeit einiger Videos ist damit eine Funktion, kein Funktionsfehler. Der Politikwissenschaftler Jordan McSwiney und der Kommunikationswissenschaftler Kurt Sengul untersuchen die Nutzung von Humor durch die radikale Rechte. Sie analysieren, dass Humor, ebenso wie Spott, in der Kommunikation der radikalen Rechten durch digitale Medien an Bedeutung gewonnen hat. Humor würde genutzt, um radikale ideologische Inhalte zu entschärfen, soziale Grenzen aufzuweichen und Botschaften zugänglicher zu machen.[23] Ausschließender Humor fördere zudem soziale Interaktionen innerhalb der Bewegung und stärke das gemeinsame Identitätsgefühl. Dieser humoristisch gestaltete Aus- und Einschluss sei Teil eines Diskurses, der solche Inhalte als »nur ein Witz« rechtfertigt. Menschenfeindliche Witze würden somit als primär unterhaltsam dargestellt, was diejenigen, die die »Witze« verbreiten, vor Vorwürfen schützen und Kritiker:innen als humorlos darstellen würde. Dadurch könnten Personen Äußerungen tätigen, die sonst als unangemessen gelten. Gleichzeitig würde signalisiert, dass solche Ansichten akzeptabel sind.[24]

Inhalte dieser Art verletzen selten die Grenzen des Legalen, wohl aber, so Politikwissenschaftlerin Ruth Wodak, die »moralischen Grenzen der Mehrheitsgesellschaft«.[25] Die Nutzung von KI-Material hat die Produktion solcher Inhalte einfacher und kostengünstiger gemacht, während über Social Media ihre Verbreitung schneller und effizienter als jemals zuvor funktioniert. Es bedarf also keiner speziellen Designfähigkeiten, um innerhalb von Sekunden Texte, Bilder und Videos erstellen und verbreiten zu lassen.

KI in der Dramaturgie der Empörung

Diese KI-generierten Inhalte sind auf mehrere Arten aufmerksamkeitserregend: KI ist ein junges Phänomen. Die Nutzung von innovativer Technologie – zunächst unabhängig von wem – ist für Medienkonsument:innen interessant.[26]

Außerdem sind die KI-Inhalte, die von rechten Akteuren generiert werden, oft darauf ausgelegt, Empörung hervorzurufen. Die KI-generierten Inhalte, die besondere mediale Resonanz erfahren haben, waren krude – aber im Sinne der Aufmerksamkeitsökonomie erfolgreich. Sie sind Teil einer bereits wohlbekannten Dramaturgie. Wodak bezeichnet dieses Vorgehen als Skandalisierung und strategische Provokation. Die Aussagen – oder Bilder und Videos – verlangen nach einer Reaktion, beispielsweise weil sie unwahr oder beleidigend sind oder einen Tabubruch darstellen. Dazu zu schweigen, wäre eine implizite Zustimmung.[27]

Die in der Regel negativen Reaktionen sind also einkalkuliert. Sie werden von Anhänger:innen rechter Parteien und Bewegungen deshalb positiv bewertet, weil sie den Tabubruch bestätigen.[28] Die Reaktionen selbst können zusätzlich als hysterisch und überzogen bezeichnet und herabgewürdigt werden. Auf diese Weise wird die forcierte Aufmerksamkeit verlängert. Die Personen, die Ziel der Angriffe waren, sowie diejenigen, die die Angriffe kritisiert haben, werden zusätzlich beschädigt.[29] Dieser Bruch mit konventionellen Regeln und Umgangsformen im politischen Miteinander ist ein integraler Bestandteil der rechten Kommunikationsstrategie geworden. Die logische Fortführung dieser Strategie liegt in der Nutzung der neuen technischen Möglichkeiten: Durch KI kann zuverlässig wie beständig mediale Aufmerksamkeit erzeugt und gesellschaftliche Empörung provoziert werden.

Während KI ein neues Mittel liefert, ist die Strategie also nicht neu; die zugrunde liegenden Mechanismen sind bereits bekannt. Es wäre nun leicht, den Einfluss einer neuen Technologie zu überschätzen. Die Forschungsstelle BAG »Gegen Hass im Netz« kommt jedoch zu dem Ergebnis, dass beispielsweise in rechten Telegram-Kanälen lediglich knapp unter fünf Prozent der analysierten Bilder durch eine KI erstellt wurden.[30] Auch die Politolog:innen Pietro Castelli Gattinara und Caterina Froio stellen bezüglich der Medienstrategie von rechten Bewegungen fest: »far-right social movements deploy media strategies with the intention of determining their own visibility in the news«.[31] Die Nutzung von KI und der Rückgriff auf strategische Skandalisierung vereinfachen es rechtsradikalen Akteuren, diese Sichtbarkeit zu erlangen. Für Medien indes sind neue Technologien und deren Nutzung berichtenswert[32] – nutzen nun rechte Akteure die Neuartigkeit von KI zusammen mit der bekannten Dramaturgie, scheint eine Berichterstattung garantiert.

Resümee

Während eine Berichterstattung über rassistische Inhalte und über die Verächtlichmachung von Personen des öffentlichen Lebens sinnvoll ist, ist die Art und Weise der Berichterstattung ausschlaggebend dafür, wie und in welchem Maße Akteure Aufmerksamkeit forcieren können. Die Einordnung der Inhalte kann dazu beitragen, dass beschädigendes Material weniger reproduziert wird. Auch die klare Benennung von Medienstrategien und ihre Einordnung sind zentral dafür, dass Inhalte erklärt und nicht unfreiwillig reproduziert werden. Eine differenzierte und kritische Auseinandersetzung mit den dargestellten Inhalten kann dazu führen, dass sie für Mechanismen der Schaffung von Öffentlichkeit im Allgemeinen sensibilisiert wird.

Literatur::

Baele, Stephen J. und Brace, Lewys: AI Extremism. Technologies, Tactics, Actors, VOX-Pol Network of Excellence, Dublin 2024.

Bender, Emily M./Gebru, Timnit/McMillian-Major, Angelina/Shmitchell, Shmargaret: On the Dangers of Stochastic Parrots. Can Language Models Be Too Big?, in: Association for Computing Machinery (Hrsg.): Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, New York 2021, S. 610–623, https://doi.org/10.1145/3442188.3445922.

Bösch, Marcus und Divon, Tom: The sound of disinformation. TikTok, computational propaganda, and the invasion of Ukraine, in: new media & society, Jg. 26 (2024), H. 9, S. 5081–5106, https://doi.org/10.1177/14614448241251804.

Bowman-Grieve, Lorraine: »Exploring Stormfront”. A Virtual Community of the Radical Right, in: Studies in Conflict & Terrorism, Jg. 32 (2009), H. 11, S. 989–1007.

Castelli Gattinara, Pietro und Froio, Caterina: Getting ‹right’ into the news. Grassroots far-right mobilization and media coverage in Italy and France, in: Comparative European Politics, Jg. 17 (2019), H. 5, S. 738–758.

Chen, Yibei/Zhai, Yujia/Sun, Shaojing: The gendered lens of AI. Examining news imagery across digital spaces, in: Journal of Computer-Mediated Communication, Jg. 29 (2024), H. 1, S. 1–11.

Donner, Christian/Böswald, Lena-Maria/Fielitz, Maik/Sick, Harald/Marcks, Holger: Attention Is All They Need. Eine Analyse der Nutzung generativer KI in rechtsalternativen Netzwerken, in: Machine Against the Rage, Nr. 7, 2024, o. S., https://doi.org/10.58668/matr/07.2.

Ferber, Dorthe: Anzeige nach »Abschiebesong« der AfD-Jugend, in: zdf.de, 23.09.2024, URL: https://www.zdf.de/nachrichten/politik/deutschland/afd-abschiebesong-wahl-brandenburg-junge-alternative-100.html [eingesehen am 20.01.2025].

Floridi, Luciano: Why the AI Hype is Another Tech Bubble, in: Philosophy & Technology, Jg. 37 (2024), H. 4, https://doi.org/10.1007/s13347-024-00817-w.

George, A. Shaji/George, A. S. Hovan/Martin, A. S. Gabrio: The Environmental Impact of AI. A Case Study of Water Consumption by Chat GPT, in: Partners Universal International Innovation, Jg. 1 (2023), H. 2, https://doi.org/10.5281/zenodo.7855594.

Hauck, Uli: Mit Friedenstauben in den Wahlkampf, in: tagesschau.de, 12.01.2025, URL: https://www.tagesschau.de/inland/bundestagswahl/parteien/bsw-wagenknecht-wahlkampf-100.html [eingesehen am 20.01.2025].

Haupt, Friederike: Die AfD macht Stimmung mit Fotos, die keine sind, in: faz.net, 31.03.2023, URL: https://www.faz.net/aktuell/politik/inland/afd-mit-ki-fotos-abgeordnete-der-partei-rechtfertigen-taeuschende-bilder-18788651.html [eingesehen am 20.01.2025].

Huesmann, Felix: Wie die AfD mit KI-Bildern Stimmung macht – und wie die anderen Parteien KI nutzen, in: rnd.de, 01.04.2024, URL: https://www.rnd.de/politik/afd-wie-die-partei-kuenstliche-intelligenz-nutzt-WJIGX6BFQVETPBYPW47YRWXHOM.html [eingesehen am 20.01.2025].

Ji, Ziwei/Nayeon, Lee/Frieske, Rita/Yu, Tiezheng/Su, Dan/Xu, Yan/Ishii, Etsuko/Bang, Ye Jin/Madotto, Andrea/Fung, Pascale: Survey of Hallucination in Natural Language Generation, in: ACM Computing Surveys, Jg. 55 (2023), H. 12, S. 1–38, https://doi.org/10.1145/3571730.

Johnson, Paul: Owning the Libs. The Contemporary Politics of Envy, in: Theory & Event, Jg. 27 (2024), H. 2, S. 233–257.

Küsters, Anselm/Poli, Eleonora/Réau, Camille/Warhem, Victor: The Threat of Digital Populism to European Democracy. A Comparative Look at Germany, Italy, and France, cepStudy 2023.

Lakomy, Miron: Artificial Intelligence as a Terrorism Enabler? Understanding the Potential Impact of Chatbots and Image Generators on Online Terrorist Activities, in: Studies in Conflict & Terrorism, 2023, S. 1–21, https://doi.org/10.1080/1057610X.2023.2259195.

McSwiney, Jordan und Sengul, Kurt: Humor, Ridicule, and the Far Right: Mainstreaming Exclusion Through Online Animation, in: Television & New Media, 2023, S. 1–19.

McSwiney, Jordan/Vaughan, Michael/Heft, Annett/Hoffmann, Matthias: Sharing the hate? Memes and transnationality in the far right‹s digital visual culture, in: Information, Communication & Society Jg. 24 (2021), H. 16, S. 2502–2521.

Metzger, Nils und Neuhann, Florian: Windräder wieder abbauen? Das sind die Folgen, in: zdf.de, 13.01.2025, URL: https://www.zdf.de/nachrichten/politik/deutschland/weidel-afd-windraeder-reinhardswald-windkraft-kritik-100.html [eingesehen am 20.01.2025].

Müller, Ann-Katrin: AfD wirbt mit Fakevideo, in: SPIEGEL ONLINE, 10.01.2025, URL: https://www.spiegel.de/politik/deutschland/wahlkampf-afd-wirbt-mit-fake-video-von-angela-merkel-a-60e9040d-28e2-4e12-ade6-873164b8a681 [eingesehen am 20.01.2025].

O. V.: Neue Strategie. Meta will Facebook und Instagram mit KI-generierten Nutzern bevölkern, in: t-online.de, 03.01.2025, URL: https://www.t-online.de/digital/aktuelles/id_100564932/facebook-und-instagram-meta-bringt-ki-charaktere-in-soziale-netzwerke.html [eingesehen am 20.01.2025].

O. V.: Parteivorsitzende monierte Bild. AfD-nahes Magazin spottet mit Heiligenbild über Weidel, in: t-online.de, 10.01.2025, URL: https://www.t-online.de/nachrichten/deutschland/innenpolitik/id_100570924/alice-weidel-afd-nahes-magazin-spottet-mit-ki-generiertem-heiligenbild-.html [eingesehen am 20.01.2025].

O. V.: Die völkischen KI-Memes von »Wilhelm Kachel«, in: deutschlandfunk.de, 29.08.2024, URL: https://www.deutschlandfunk.de/rechtsextreme-memes-kuenstliche-intelligenz-wilhelm-kachel-propaganda-100.html [eingesehen am 20.01.2025].

OpenAI: Introducing ChatGPT, URL: https://openai.com/index/chatgpt/ [eingesehen am 16.01.2025].

Quesada, José Antonio Cortés/Ugarte, Teresa Barceló/Cortina, Gonzalo Fuentes: Audio-visual consumption of Millennials and Generation Z: preference for snackable content, in: Doxa Comunicación, Jg. 36 (2023), S. 303–320, https://doi.org/10.31921/doxacom.n36a1687.

Shoaib, Mohamed R./Wang, Zefan/Ahvanooey, Milad Taleby/Zhao, Jun: Deepfakes, Misinformation, and Disinformation in the Era of Frontier AI, Generative AI, and Large AI Models, in: 2023 International Conference on Computer and Applications (ICCA), 2023, S. 1–7, https://doi.org/10.1109/ICCA59364.2023.10401723.

Wodak, Ruth: The Strategy of Discursive Provocation: A Discourse-Historical Analysis of the FPÖ‹s Discriminatory Rhetoric, in: Feldman, Matthew/Jackson, Paul (Hrsg.): Doublespeak: The Rhetoric of the Far Right since 1945, Stuttgart 2014, S. 101–119.

Wodak, Ruth/Culpeper, Jonathan/Semino, Elena: Shameless normalisation of impoliteness: Berlusconi’s and Trump’s press conferences, in: Discourse & Society Jg. 32 (2021), H. 3, S. 369–393.

[1]Vgl. Hauck, Uli: Mit Friedenstauben in den Wahlkampf, in: tagesschau.de, 12.01.2025, URL: https://www.tagesschau.de/inland/bundestagswahl/parteien/bsw-wagenknecht-wahlkampf-100.html [eingesehen am 20.01.2025].

[2]Vgl. Müller, Ann-Katrin: AfD wirbt mit Fakevideo, in: SPIEGEL, 10.01.2025, URL: https://www.spiegel.de/politik/deutschland/wahlkampf-afd-wirbt-mit-fake-video-von-angela-merkel-a-60e9040d-28e2-4e12-ade6-873164b8a681 [eingesehen am 20.01.2025].

[3]Vgl. o. V.: AfD-nahes Magazin spottet mit Heiligenbild über Weidel, in: t-online.de, 10.01.2025, URL: https://www.t-online.de/nachrichten/deutschland/innenpolitik/id_100570924/alice-weidel-afd-nahes-magazin-spottet-mit-ki-generiertem-heiligenbild-.html [eingesehen am 20.01.2025].

[4]Vgl. OpenAI: Introducing ChatGPT, URL: https://openai.com/index/chatgpt/ [eingesehen am 16.01.2025].

[5]Vgl. Floridi, Luciano: Why the AI Hype is Another Tech Bubble, in: Philosophy & Technology, Jg. 37 (2024), H. 4, hier S. 128, https://doi.org/10.1007/s13347-024-00817-w.

[6]Vgl. George, A. Shaji/George, A. S. Hovan/Martin, A. S. Gabrio: The Environmental Impact of AI. A Case Study of Water Consumption by Chat GPT, in: Partners Universal International Innovation, Jg. 1 (2023), H. 2, https://doi.org/10.5281/zenodo.7855594.

[7]Vgl. Ji, Ziwei et al.: Survey of Hallucination in Natural Language Generation, in: ACM Computing Surveys, Jg. 55 (2023), H. 12, S. 1–38, https://doi.org/10.1145/3571730.

[8]Vgl. Bender, Emily M. et al.: On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?, in: Association for Computing Machinery (Hrsg.): Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, New York 2021, S. 610–623, https://doi.org/10.1145/3442188.3445922.

[9]Vgl. Shoaib, Mohamed R. et al.: Deepfakes, Misinformation, and Disinformation in the Era of Frontier AI, Generative AI, and Large AI Models, in: 2023 International Conference on Computer and Applications (ICCA), 2023, S. 1–7, https://doi.org/10.1109/ICCA59364.2023.10401723.

[10]Vgl. Lakomy, Miron: Artificial Intelligence as a Terrorism Enabler? Understanding the Potential Impact of Chatbots and Image Generators on Online Terrorist Activities, in: Studies in Conflict & Terrorism, 2023, S. 1–21, https://doi.org/10.1080/1057610X.2023.2259195.

[11]Vgl. Baele, Stephen J. und Brace, Lewys: AI Extremism. Technologies, Tactics, Actors, Dublin 2024, S. 24.

[12]Vgl. Lakomy: Artificial Intelligence as a Terrorism Enabler?, S. 5.

[13]Vgl. o. V.: Meta will Facebook und Instagram mit KI-generierten Nutzern bevölkern, in: t-online.de, 03.01.2025, URL: https://www.t-online.de/digital/aktuelles/id_100564932/facebook-und-instagram-meta-bringt-ki-charaktere-in-soziale-netzwerke.html [eingesehen am 20.01.2025].

[14]Vgl. Metzger, Nils und Neuhann, Florian: Windräder wieder abbauen? Das sind die Folgen, in: zdf.de, 13.01.2025, URL: https://www.zdf.de/nachrichten/politik/deutschland/weidel-afd-windraeder-reinhardswald-windkraft-kritik-100.html [eingesehen am 20.01.2025].

[15]Vgl. Huesmann, Felix: Wie die AfD mit KI-Bildern Stimmung macht – und wie die anderen Parteien KI nutzen, in: rnd.de, 01.04.2024, URL: https://www.rnd.de/politik/afd-wie-die-partei-kuenstliche-intelligenz-nutzt-WJIGX6BFQVETPBYPW47YRWXHOM.html [eingesehen am 20.01.2025].

[16]Küsters, Anselm et al.: The Threat of Digital Populism to European Democracy. A Comparative Look at Germany, Italy, and France, cepStudy 2023, S. 16.

[17]Vgl. Haupt, Friederike: Die AfD macht Stimmung mit Fotos, die keine sind, in: faz.net, 31.03.2023, URL: https://www.faz.net/aktuell/politik/inland/afd-mit-ki-fotos-abgeordnete-der-partei-rechtfertigen-taeuschende-bilder-18788651.html [eingesehen am 20.01.2025].

[18]Vgl. Quesada, José Antonio Cortés/Ugarte, Teresa Barceló/Cortina, Gonzalo Fuentes: Audio-visual consumption of Millennials and Generation Z: preference for snackable content, in: Doxa Comunicación, Jg. 36 (2023), S. 303–320, https://doi.org/10.31921/doxacom.n36a1687.

[19]Vgl. Bösch, Marcus und Divon, Tom: The sound of disinformation. TikTok, computational propaganda, and the invasion of Ukraine, in: new media & society, Jg. 26 (2024), H. 9, S. 5081–5106, https://doi.org/10.1177/14614448241251804.

[20]Donner, Christian et al.: Attention Is All They Need. Eine Analyse der Nutzung generativer KI in rechtsalternativen Netzwerken, in: Machine Against the Rage, H. 7/2024, o. S., https://doi.org/10.58668/matr/07.2.

[21]Vgl. Ferber, Dorthe: Anzeige nach »Abschiebesong« der AfD-Jugend, in: zdf.de, 23.09.2024, URL: https://www.zdf.de/nachrichten/politik/deutschland/afd-abschiebesong-wahl-brandenburg-junge-alternative-100.html [eingesehen am 20.01.2025].

[22]Donner: Attention Is All They Need, o. S.

[23]Vgl. McSwiney, Jordan et al.: Sharing the hate? Memes and transnationality in the far right‹s digital visual culture, in: Information, Communication & Society Jg. 24 (2021), H. 16, S. 2502–2521, hier S. 2516

[24]Vgl. McSwiney, Jordan und Sengul, Kurt: Humor, Ridicule, and the Far Right: Mainstreaming Exclusion Through Online Animation, in: Television & New Media, 2023, 1–19, hier S. 6–7.

[25]Wodak, Ruth: The Strategy of Discursive Provocation. A Discourse-Historical Analysis of the FPÖ‹s Discriminatory Rhetoric, in: Feldman, Matthew/Jackson, Paul (Hrsg.): Doublespeak. The Rhetoric of the Far Right since 1945, Stuttgart 2014, S. 101–119, hier S. 101–102 (eigene Übersetzung).

[26]Vgl. Bowman-Grieve, Lorraine: Exploring »Stormfront”. A Virtual Community of the Radical Right, in: Studies in Conflict & Terrorism, Jg. 32 (2009), H. 11, S. 989–1007, hier S. 990.

[27]Vgl. Wodak, Ruth: The Strategy of Discursive Provocation, S. 102.

[28]Vgl. Wodak, Ruth: The Strategy of Discursive Provocation: A Discourse-Historical Analysis of the FPÖ‹s Discriminatory Rhetoric, in: Feldman, Matthew/Jackson, Paul (Hrsg.): Doublespeak: The Rhetoric of the Far Right since 1945, Stuttgart 2014, S. 101–119..

[29]Vgl. Johnson, Paul: Owning the Libs. The Contemporary Politics of Envy, in: Theory & Event, Jg. 27 (2024), H. 2, S. 233–257, hier S. 235–236.

[30]Vgl. Donner: Attention Is All They Need, o. S.

[31]Castelli Gattinara, Pietro und Froio, Caterina: Getting ‹right’ into the news. Grassroots far-right mobilization and media coverage in Italy and France, in: Comparative European Politics, Jg. 17 (2019), H. 5, S. 738–758, hier S. 739.

[32]Vgl. Chen, Yibei/Zhai, Yujia/Sun, Shaojing: The gendered lens of AI. Examining news imagery across digital spaces, in: Journal of Computer-Mediated Communication, Jg. 29 (2024), H. 1, S. 1–11, hier S. 3.